Tất cả chuyên mục

Nền tảng Chatbot Arena đã mang đến một cách đánh giá AI hoàn toàn mới.

Cũng như bảng xếp hạng Billboard Hot 100 là thước đo tiêu chuẩn cho độ phổ biến của các sản phẩm âm nhạc, các chatbot Trí tuệ Nhân tạo (AI) cũng có một “đấu trường” riêng được xây dựng và điều hành bởi hai nghiên cứu sinh mang tên “Chatbot Arena”.

Hai người bạn cùng phòng Anastasios Angelopoulos và Wei-Lin Chiang không ngờ rằng dự án nghiên cứu của họ đã nhanh chóng trở thành bảng xếp hạng được theo dõi nhiều nhất về các hệ thống AI.

Cách mới để đánh giá AIRa mắt vào tháng 4/2023, Chatbot Arena nhanh chóng trở thành một hiện tượng khi thu hút hơn 4.700 lượt bình chọn chỉ trong tuần đầu tiên.

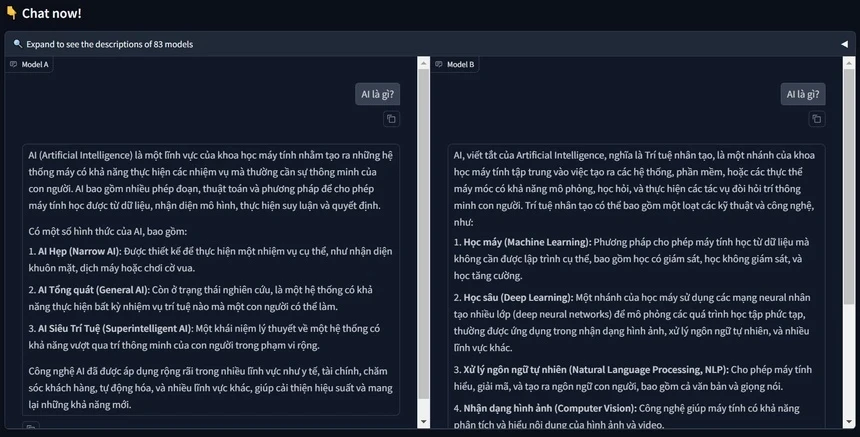

Theo truyền thống, hiệu năng của các công nghệ AI được đánh giá qua các bài kiểm tra chuyên sâu về toán học, khoa học và luật pháp. Tuy nhiên, Chatbot Arena cung cấp một phương pháp đánh giá mới, cho phép người dùng trực tiếp so sánh khả năng của các mô hình AI thông qua việc đặt câu hỏi và nhận câu trả lời.

Những đánh giá này được tổng hợp thành một bảng xếp hạng, nơi các tên tuổi lớn của Thung lũng Silicon như OpenAI, Google và Meta Platforms tranh giành ngôi vị cao nhất.

“Mọi người đều đang cố gắng để đứng đầu bảng xếp hạng này, thật tuyệt vời khi một vài sinh viên tập hợp lại và có thể tạo ra tác động to lớn như vậy”, Joseph Spisak, giám đốc quản lý sản phẩm tại Meta Platforms, cho biết.

Khi cuộc đua AI ngày càng “nóng lên”, bất kỳ lợi thế nào so với đối thủ cạnh tranh cũng có thể tạo ra sự khác biệt lớn trong việc thu hút khách hàng và nhân tài. Điều này càng khiến Chatbot Arena thu hút sự chú ý.

Từ khi ra mắt với chỉ 9 mô hình AI, Chatbot Arena đã không ngừng mở rộng, hiện nay đã đánh giá và xếp hạng hơn 170 mô hình khác nhau với hơn hai triệu lượt bình chọn. Nền tảng này cũng cung cấp các bảng xếp hạng chi tiết cho nhiều lĩnh vực như sáng tạo nội dung và lập trình.

Chatbot Claude của Anthropic hiện đứng đầu bảng xếp hạng, sau khi soán ngôi OpenAI vào tháng 3 năm nay.

Đánh giá theo cảm tínhCác nhà nghiên cứu đã nhận thấy rằng các bài kiểm tra học thuật truyền thống đang dần mất đi hiệu lực. Nguyên nhân là do các câu hỏi trong những bài kiểm tra này đã được tích hợp vào các mô hình ngôn ngữ lớn (LLM), giúp các hệ thống AI học thuộc và trả lời một cách máy móc, qua đó làm giảm tính khách quan của kết quả đánh giá.

Google và OpenAI đã đạt được điểm số trên 90% trong bài kiểm tra Đo lường Hiểu biết Ngôn ngữ Đa nhiệm Khổng lồ (MMLU), một tiêu chuẩn đánh giá khả năng hiểu ngôn ngữ của các mô hình AI đã được sử dụng rộng rãi trong bốn năm qua.

Dan Hendrycks, một trong những người tạo ra bài kiểm tra này, đã phát động chiến dịch kêu gọi cộng đồng cùng nhau xây dựng một bộ câu hỏi cực khó, được ông đặt tên là "Bài kiểm trí tuệ nhân tạo cuối cùng". Mục tiêu của dự án này là đặt ra những câu hỏi hóc búa nhất để đánh giá toàn diện khả năng của các hệ thống AI.

"Mặc dù một chuẩn đánh giá ban đầu có thể rất khó đối với các LLM, những thế hệ LLM tiếp theo sẽ xuất hiện và đạt được hiệu suất gần như hoàn hảo", Tiến sĩ Colin White, Giám đốc Nghiên cứu tại Abacus.AI, đơn vị phát triển chuẩn đánh giá AI LiveBench, cho biết.

Cách tiếp cận "đối đầu" của Chatbot Arena, mặc dù thú vị, không phải lúc nào cũng đảm bảo tính chính xác và khách quan. Việc đánh giá dựa trên cảm nhận cá nhân khó có thể đo lường được các tiêu chí cụ thể của một chatbot. Do đó, một số nhà nghiên cứu gọi cách tiếp cận này là "đánh giá dựa trên cảm nhận".

Đội ngũ phát triển Chatbot Arena đã rất thẳng thắn trong việc công khai các hạn chế của nền tảng. Để giúp người dùng có cái nhìn khách quan hơn, họ cho phép người dùng tự do loại bỏ những yếu tố chủ quan như độ dài câu trả lời hay định dạng khi đánh giá các mô hình.

Đóng góp cho cộng đồngAngelopoulos và Chiang đã kêu gọi nhiều nhà nghiên cứu khác để cùng xây dựng một nền tảng tương tự như Wikipedia, nơi cộng đồng có thể cùng nhau đóng góp và phát triển kiến thức về Trí tuệ Nhân tạo. Quan trọng hơn, họ khẳng định rằng dự án này hoàn toàn phi lợi nhuận.

Chatbot Arena cũng đóng vai trò quan trọng trong việc thúc đẩy sự phát triển của cộng đồng AI. Nhờ nền tảng này, người dùng có thể khám phá ra các mô hình ngôn ngữ mới. Điển hình là sự xuất hiện bất ngờ của "im-also-a-good-gpt2-chatbot", sau đó được xác nhận là GPT-4o.

Theo Chatbot Arena, xAI của Elon Musk, Meta và Google cũng đã thử nghiệm các công nghệ trên trang web trước khi được phát hành rộng rãi.

"Chúng tôi nhận được yêu cầu từ các công ty mỗi ngày”, nhà đồng sáng lập Chiang cho biết.

Vào tháng 10, một mô hình AI từ công ty Trung Quốc có tên “01.AI” đã bất ngờ xuất hiện ở vị trí thứ 6 trên bảng xếp hạng, thu hút sự chú ý đến những tiến bộ của Trung Quốc trong lĩnh vực này.

Kai-Fu Lee, cựu giám đốc điều hành Google và hiện là CEO của 01.AI, đã quảng bá thành tích này trên nền tảng X. Ông cho biết mô hình này đã vượt qua phiên bản đầu tiên của GPT-4o của OpenAI.

Những phản hồi của người dùng trên Chatbot Arena đã trở thành một kho dữ liệu quý giá đối với các nhà phát triển. Angelopoulos và Chiang cho biết họ đã chia sẻ khoảng 20% dữ liệu này, để cộng đồng nghiên cứu có thể tận dụng mà không làm ảnh hưởng đến tính bảo mật và công bằng của nền tảng.

Ý kiến ()