Tất cả chuyên mục

Kẻ xấu có thể tấn công vào các trợ lý ảo AI thông qua một cuộc tấn công “tiêm lệnh”, nhập những câu lệnh độc hại vào các mô hình ngôn ngữ lớn.

Số lượng cuộc tấn công liên quan đến trí tuệ nhân tạo (AI) đang leo thang nhanh chóng. Thông tin này vừa được Kaspersky chia sẻ tại Hội nghị thượng đỉnh trọng điểm về an ninh mạng diễn ra hồi đầu tháng 8 tại Sri Lanca.

Theo các chuyên gia, có thể chia các cuộc tấn công bằng AI thành hai loại chính. Đầu tiên là sử dụng AI để tự động hóa quy trình hoặc tìm ra các phương thức tấn công mạng mới. Ví dụ điển hình là cách mà nhiều kẻ lừa đảo sử dụng công nghệ Deepfake. Thể loại tấn công bằng AI thứ hai là lợi dụng lỗ hổng để thao túng các mô hình ngôn ngữ lớn thực hiện hành động ngoài ý muốn.

Trên thực tế, sự phát triển nhanh chóng của trí tuệ nhân tạo thời gian gần đây đang đặt ra những thách thức với ngành bảo mật. Theo kết quả một nghiên cứu vừa công bố của Kaspersky, AI có thể bẻ khóa mật khẩu nhanh hơn 3 lần so với cách thông thường. Nguy hiểm hơn khi 78% mật khẩu có thể bị AI bẻ khóa trong vòng chưa đầy 60 phút.

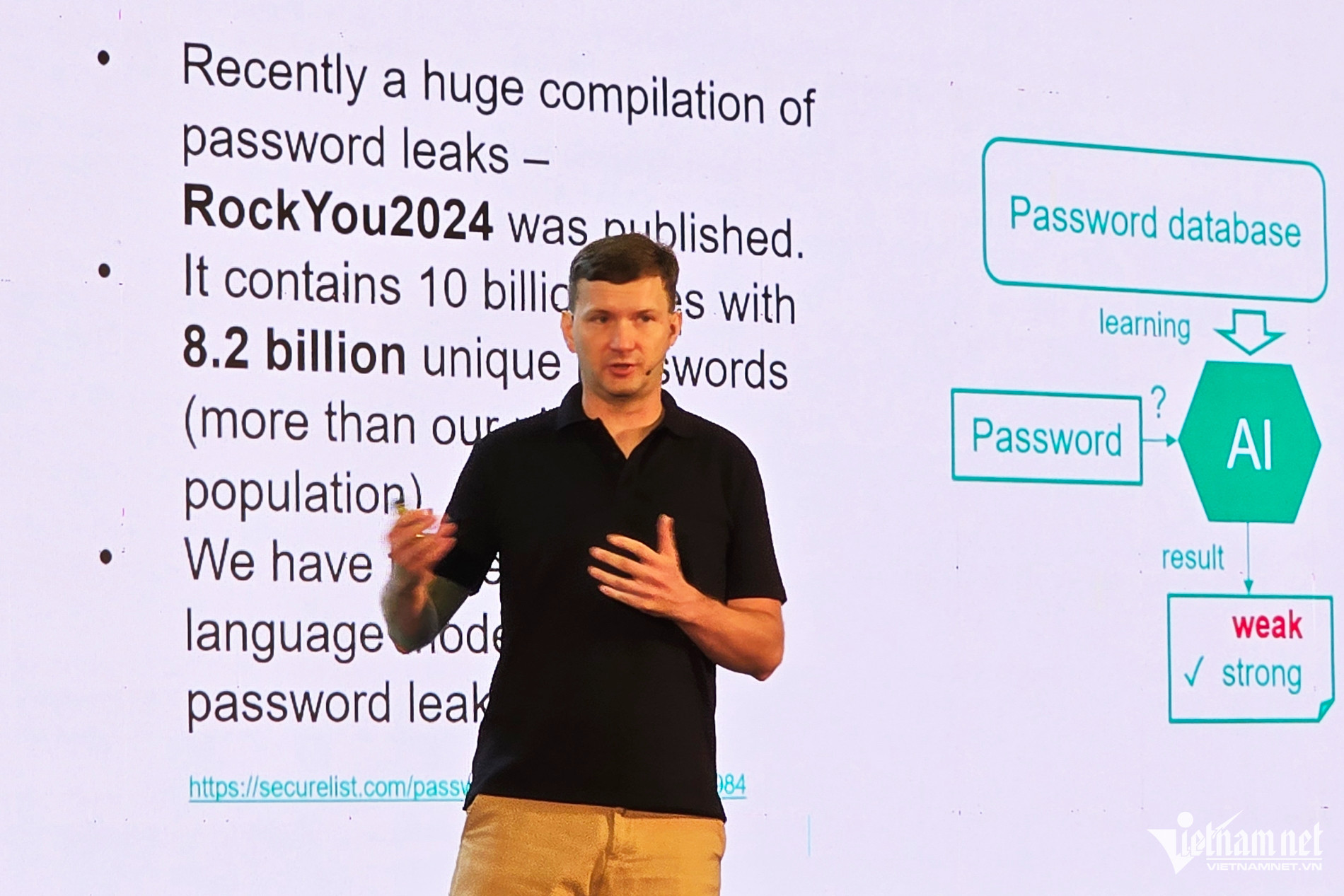

Tháng 7 vừa qua, thế giới chứng kiến vụ rò rỉ mật khẩu lớn nhất từng bị phát tán trực tuyến. Đó là vụ rò rỉ mật khẩu RockYou2024, chứa 10 tỷ mật khẩu dưới dạng văn bản và 8,2 tỷ mật khẩu chứa ký tự đặc biệt.

Phân tích dữ liệu thu được từ sự cố này, ông Alexey Antonov - Trưởng nhóm Khoa học Dữ liệu tại Kaspersky, cho biết 32% mật khẩu người dùng hiện không đủ mạnh. Dù đã được mã hóa ở dạng “hàm băm”, nhưng những mật khẩu này vẫn có thể khôi phục về dạng văn bản thuần túy. Bằng thuật toán đơn giản, công đoạn khôi phục chỉ mất khoảng 60 phút.

“Để kiểm tra mức độ bảo mật của mật khẩu, chúng tôi đào tạo mô hình ngôn ngữ (language model) dùng các mật khẩu đã lộ làm dữ liệu đầu vào. Kết quả là, có đến 78% mật khẩu có khả năng bị bẻ khóa theo cách kể trên. Chỉ có 7% mật khẩu đủ mạnh để phòng chống các cuộc tấn công lâu dài”, chuyên gia Alexey Antonov nhận định.

Không chỉ sử dụng để dò tìm mật khẩu, trí tuệ nhân tạo đang được các hacker vận dụng vào nhiều kịch bản tấn công. Trên thực tế, ChatGPT có thể bị kẻ xấu lợi dụng để viết các phần mềm độc hại.

Thông qua AI, kẻ xấu khai thác các nội dung lừa đảo, bao gồm văn bản, hình ảnh, âm thanh và video để triển khai tấn công phi kỹ thuật. Những mô hình ngôn ngữ lớn như ChatGPT-4o đang bị tận dụng để tạo ra kịch bản và tin nhắn lừa đảo vô cùng tinh vi.

Vượt qua rào cản ngôn ngữ, AI có thể viết ra một email chân thật, chỉ cần dựa vào thông tin trên mạng xã hội. Thậm chí, AI có thể bắt chước văn phong của nạn nhân. Điều này càng khiến hành vi lừa đảo khó bị phát hiện hơn.

Một trong những nguy cơ từ AI là việc kẻ xấu lợi dụng công nghệ Deepfake để mạo danh người khác, từ đó thực hiện các hành vi lừa đảo nhằm trục lợi tài chính thông qua việc gọi điện cho bạn bè, người thân.

Theo chuyên gia Alexey Antonov, ngoài việc lợi dụng công nghệ AI vào những hoạt động phi pháp, kẻ xấu còn có thể tấn công vào cả những thuật toán AI. Điều này được thực hiện thông qua những cuộc tấn công “tiêm lệnh” (Prompt Injection attacks), nhập những câu lệnh độc hại, đi ngược những quy tắc hạn chế vào các mô hình ngôn ngữ lớn. Những “câu lệnh bẩn” sẽ tác động, làm sai lệch nội dung kết quả trả về của trợ lý ảo.

Bên cạnh đó, trí tuệ nhân tạo còn có thể được sử dụng trong các cuộc tấn công đối kháng (Adversarial attacks). Đó là khi kẻ xấu thêm những trường thông tin ẩn vào hình ảnh, hoặc âm thanh, để gây ảnh hưởng đến khả năng phân loại hình ảnh của hệ thống học máy.

Trong bối cảnh AI dần được tích hợp vào mọi khía cạnh trong đời sống con người, từ Apple Intelligence, Google Gemini cho đến Microsoft Copilot, các chuyên gia cho rằng, việc giải quyết những lỗ hổng AI nên được xem là ưu tiên hàng đầu.

Ý kiến ()